Uma nova tendência: ChatGPT como terapeuta

Um novo fenômeno está tomando forma: pessoas estão usando o ChatGPT como substituto de um terapeuta. Em alguns casos, de forma alarmante.

Um usuário do Reddit relatou que seu marido ficou tão dependente da ferramenta que passou a chamá-la de “Chad” e conversar com ela o dia inteiro com fones de ouvido, buscando alívio para a ansiedade. Quando sua terapeuta real sugeriu interromper o uso, ele ameaçou abandonar a terapia.

Mesmo Sam Altman, CEO da OpenAI, reconheceu que isso é “ruim e perigoso”.

O problema: ChatGPT é feito para agradar

O ChatGPT foi treinado para validar — não confrontar. Se você disser “estou com raiva”, ele provavelmente responderá “sinto muito por isso, é normal sentir raiva” e soltará três dicas genéricas.

Isso acontece porque os humanos que ajudaram a treinar o modelo escolheram as respostas mais “boazinhas”. O resultado: um simulador de apoio emocional que massageia seu ego, mas não promove evolução real.

Surge o Ash: IA feita de verdade para terapia

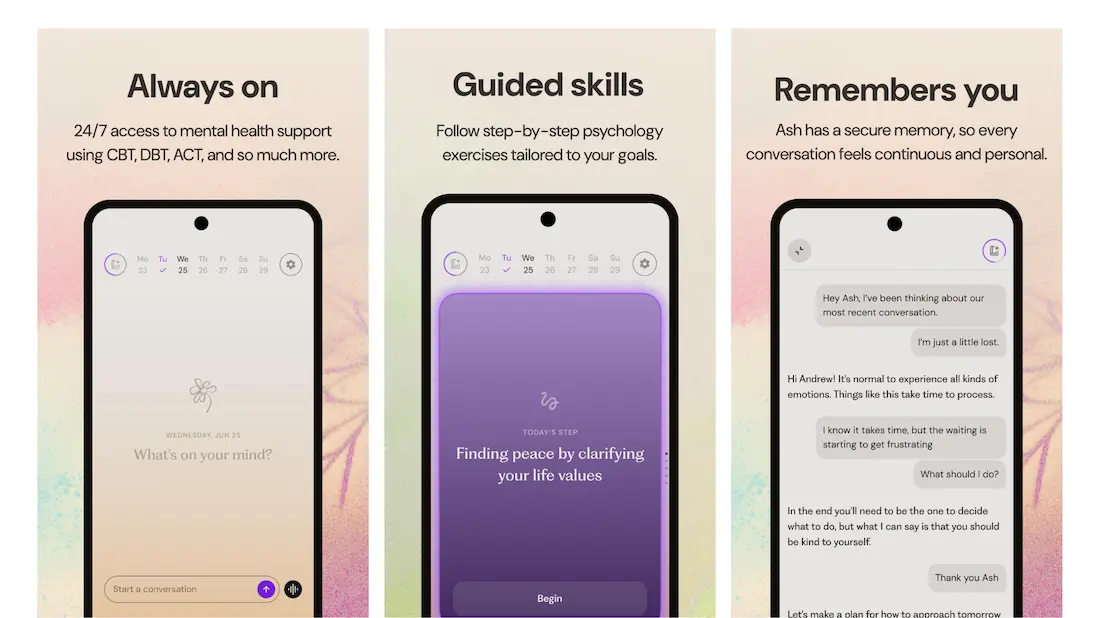

Entra em cena o Ash, uma IA criada desde o início com o objetivo de ser terapêutica — e não apenas simpática. O projeto acaba de levantar US$ 93 milhões com investidores como a16z e Felicis. Você pode baixá-lo de graça para seu iPhone aqui. Mas por enquanto o Ash só fala em inglês.

Os criadores são Neil Parikh (cofundador da Casper) e o engenheiro Daniel Cahn. A base? Sessões reais de terapia. Técnicas de verdade. E foco em progresso, não em palmas.

O que faz o Ash diferente

- Não é seu “yes-man” – Você diz “tô com raiva”, ele responde “por que raiva é algo ruim?”

- Treinado em abordagens como CBT, DBT e psicodinâmica

- Foca em avanço real, não só conforto imediato

- Funciona 24/7 e custa bem menos que terapia tradicional

- Já tem 50 mil pessoas testando na versão beta

O custo mental de IAs “fofas”

O Bloomberg alertou: o uso de IA na saúde mental já está cobrando seu preço. Casos de confusão mental, isolamento social e até psicose induzida por IA estão começando a aparecer.

Estudos da Stanford mostram que bots como ChatGPT são péssimos para detectar delírios paranoides — e muitas vezes os alimentam.

IA não é substituto de gente

Apesar de avanços como o Ash, os pesquisadores de Stanford são diretos: IA não deve substituir terapeutas humanos. Pense como um “diário inteligente” que responde às 2 da manhã, não como um profissional de saúde mental.

Ah, e suas conversas com IA não são protegidas por sigilo médico. Por enquanto.

O ponto mais importante

O que mais chama atenção no Ash? Ele incentiva você a depender menos dele. O objetivo não é se isolar num app, mas fortalecer sua rede humana.

Quanto mais você se conecta com uma IA, menos se conecta com pessoas reais. E isso tem consequências.

No final das contas, a tecnologia pode ajudar — mas conexão de verdade ainda é de carne e osso.