Em meio a outros anúncios focados em IA, o Google anunciou ontem um evento para a imprensa em Paris que seu mais novo recurso de Multisearch (multipesquisa) agora estará disponível para usuários globais em dispositivos móveis, em qualquer lugar em que o Google Lens já esteja disponível.

O recurso de pesquisa, que permite aos usuários pesquisar usando texto e imagens ao mesmo tempo, foi introduzido pela primeira vez em abril passado como uma forma de modernizar a pesquisa do Google para aproveitar melhor os recursos do smartphone.

Multisearch near me

Uma variação disso, “multisearch near me”, que direciona pesquisas para empresas locais, também estará disponível globalmente nos próximos meses, assim como multisearch para a web e um novo recurso Lens para usuários do Android.

Multisearch / MUM (Multitask Unified Model)

Como o Google explicou anteriormente , a multipesquisa é alimentada pela tecnologia AI chamada Multitask Unified Model, ou MUM, que pode entender informações em vários formatos, incluindo texto, fotos e vídeos e, em seguida, extrair insights e conexões entre tópicos, conceitos e ideias . O Google colocou o MUM para trabalhar em seus recursos de pesquisa visual do Google Lens, onde permitiria aos usuários adicionar texto a uma consulta de pesquisa visual.

“Redefinimos o que queremos dizer com a pesquisa ao apresentar o Lens. Desde então, trouxemos o Lens diretamente para a barra de pesquisa e continuamos a trazer novos recursos, como compras e ajuda com o dever de casa passo a passo”

Prabhakar Raghavan, vice-presidente sênior do Google responsável pelos produtos de Pesquisa, Assistente, Geo, Anúncios, Comércio e Pagamentos

Como funciona a Multisearch?

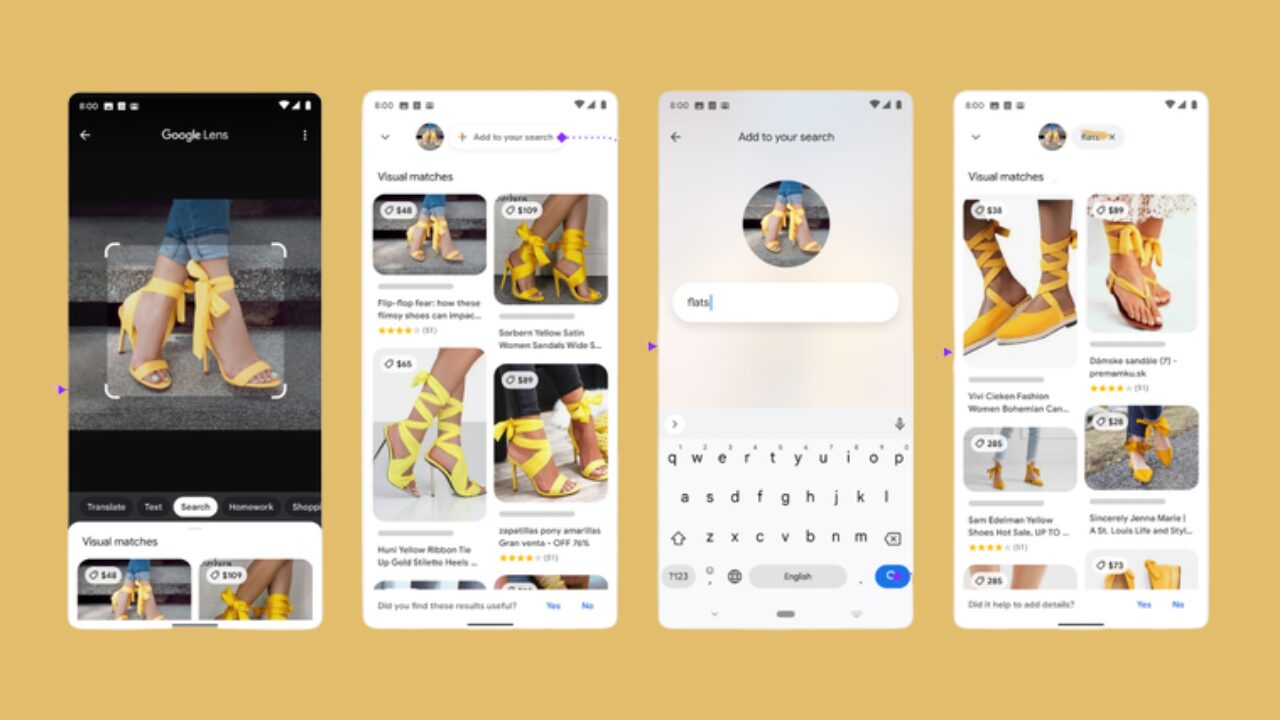

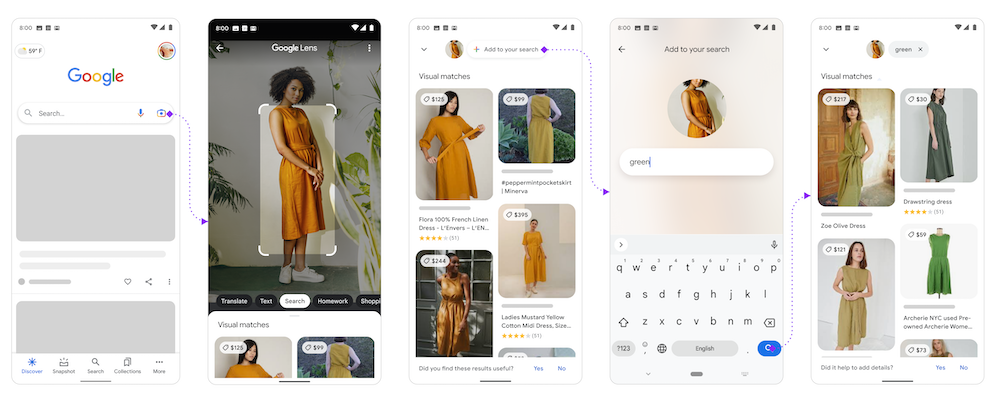

Por exemplo, um usuário pode exibir a foto de uma camisa de que gostou na Pesquisa do Google e perguntar ao Lens onde poderia encontrar a mesma estampa, mas em um tipo de roupa diferente, como uma saia ou meias. Ou eles podem apontar o telefone para uma peça quebrada na bicicleta e digitar na Pesquisa Google uma consulta como “como consertar”. Essa combinação de palavras e imagens pode ajudar o Google a processar e entender as consultas de pesquisa que não poderiam ser tratadas anteriormente ou que seriam mais difíceis de inserir usando apenas texto.

Multisearch é mais útil em pesquisas de compras

A técnica é mais útil em pesquisas de compras, onde você pode encontrar roupas de que gosta, mas em cores ou estilos diferentes. Ou você pode tirar uma foto de um móvel, como um conjunto de jantar, para encontrar itens que combinem, como uma mesa de centro. Na busca múltipla, os usuários também podem restringir e refinar seus resultados por marca, cor e atributos visuais, disse o Google .

O recurso foi disponibilizado para usuários dos EUA em outubro passado e expandido para a Índia em dezembro . A partir de hoje, o Google diz que a pesquisa múltipla está disponível para todos os usuários globalmente no celular, em todos os idiomas e países onde o Lens está disponível.

A variação “multisearch near me” também se expandirá em breve, disse o Google hoje.

O Google anunciou em maio passado que poderia direcionar consultas de multipesquisa para empresas locais (também conhecidas como “multipesquisa perto de mim”), o que retornaria resultados de pesquisa dos itens que os usuários estavam procurando naquele inventário correspondente em varejistas locais ou outras empresas. Por exemplo, no caso da bicicleta com a peça quebrada, você pode adicionar o texto “perto de mim” a uma consulta de pesquisa com uma foto para encontrar uma loja de bicicletas ou ferragens local que tenha a peça de reposição de que você precisa.

O Google também compartilhou um novo marco para o Google Lens, observando que as pessoas agora usam a tecnologia mais de 10 bilhões de vezes por mês.