Com os recentes avanços no aprendizado de máquina, podemos estar entrando em um período de progressão tecnológica mais impactante do que a Revolução Científica e a Revolução Industrial juntas. O desenvolvimento de arquiteturas de transformadores e modelos massivos de aprendizado profundo treinados em milhares de GPUs levou ao surgimento de programas inteligentes e complexos capazes de entender e produzir linguagem de uma maneira indistinguível dos humanos.

A noção de que o texto é uma interface universal que pode codificar todo o conhecimento humano e ser manipulado por máquinas cativou matemáticos e cientistas da computação por décadas. Os enormes modelos de linguagem que surgiram apenas nos últimos anos são agora a prova de que esses pensadores estavam em algo profundo. Modelos como o GPT-4 já são capazes não apenas de escrever de forma criativa, mas também de codificar, jogar xadrez e responder a consultas complexas.

O sucesso desses modelos e sua rápida melhoria por meio de escalonamento e treinamento incrementais sugerem que as arquiteturas de aprendizado disponíveis hoje podem em breve ser suficientes para gerar uma inteligência artificial geral. Pode ser que novos modelos sejam necessários para produzir inteligência geral artificial (AGI), mas se os modelos existentes estiverem no caminho certo, o caminho para a inteligência geral artificial pode resultar em um problema econômico – o que é preciso para conseguir o dinheiro e energia necessária para treinar um modelo suficientemente grande?

Em um momento de avanço tão alucinante, é importante examinar os fundamentos que sustentam as tecnologias que certamente mudarão o mundo como o conhecemos.

Além do Teste de Turing com LLMs

Modelos de linguagem grande (LLMs) como GPT-4 ou GPT-3 são os sistemas computacionais mais poderosos e complexos já construídos. Embora muito pouco se saiba sobre o tamanho do modelo GPT-4 da OpenAI, sabemos que o GPT-3 é estruturado como uma rede neural profunda composta por 96 camadas e mais de 175 bilhões de parâmetros . Isso significa que apenas executar esse modelo para responder a uma consulta inocente via ChatGPT requer trilhões de operações de computadores individuais.

Depois de ser lançado em junho de 2020, o GPT-3 rapidamente demonstrou que era formidável. Ele provou ser sofisticado o suficiente para redigir contas , passar em um exame de MBA na Wharton e ser contratado como um dos principais engenheiros de software do Google (qualificado para ganhar um salário de US$ 185.000). Além disso, poderia marcar 147 em um teste de QI verbal, colocando-o no 99º percentil da inteligência humana.

No entanto, essas realizações empalidecem em comparação com o que o GPT-4 pode fazer. Embora a OpenAI tenha permanecido particularmente discreta sobre o tamanho e a estrutura do modelo, além de dizer: “Nos últimos dois anos, reconstruímos toda a nossa pilha de aprendizado profundo e, junto com o Azure, projetamos um supercomputador desde o início para nossa carga de trabalho.” Ele chocou o mundo quando revelou exatamente o que esse modelo totalmente redesenhado poderia fazer.

A certa altura, a maneira comumente aceita de detectar inteligência de computador em nível humano era o teste de Turing. Se uma pessoa não pudesse distinguir se estava conversando com um ser humano ou com um computador apenas pela fala, poderia ser concluído que o computador era inteligente. Agora está claro que esse benchmark sobreviveu à sua relevância. Outro teste é necessário para identificar o quão inteligente é o GPT-4.

Conforme avaliado por uma variedade de referências profissionais e acadêmicas, o GPT-4 está essencialmente no 90º percentil superior da inteligência humana. Pontuou acima de 700 em SAT Reading & Writing e SAT Math, o que é suficiente para admissão em muitas universidades da Ivy League. Ele também marcou 5s (a pontuação máxima possível em uma escala de 1 a 5) em matérias de AP que vão desde História da Arte, Biologia, Estatística, Macroeconomia, Psicologia e outras. Notavelmente, ele também pode lembrar e consultar informações provenientes de até 25.000 palavras, o que significa que pode responder a um prompt de até 25.000 palavras.

Na verdade, chamar o GPT-4 de modelo de linguagem não é muito correto. O texto não é tudo o que ele pode fazer. O GPT-4 é o primeiro modelo multimodal já produzido, o que significa que decifra texto e imagens. Em outras palavras, ele pode entender e resumir o contexto de um artigo de física tão facilmente quanto uma captura de tela de um artigo de física. Além disso, ele também pode codificar, ensiná-lo no método socrático e compor desde roteiros até músicas.

A magia do modelo transformador

O segredo por trás do sucesso de grandes modelos de linguagem é sua arquitetura única. Essa arquitetura surgiu há apenas seis anos e desde então passou a dominar o mundo da inteligência artificial.

Quando o campo surgiu pela primeira vez, a lógica operacional era que cada rede neural deveria ter uma arquitetura única voltada para a tarefa específica que precisava realizar. A suposição era que decifrar imagens exigiria um tipo de estrutura de rede neural, enquanto a leitura de texto exigiria outro. No entanto, restava quem acreditasse que poderia existir uma estrutura de rede neural capaz de realizar qualquer tarefa que lhe fosse solicitada, da mesma forma que uma arquitetura de chip pode ser generalizada para executar qualquer programa. Como o CEO da Open AI, Sam Altman, escreveu em 2014 :

“Andrew Ng, que… trabalha na IA do Google, disse que acredita que o aprendizado vem de um único algoritmo – a parte do seu cérebro que processa a entrada de seus ouvidos também é capaz de aprender a processar a entrada de seus olhos. Se nós pode apenas descobrir este algoritmo de propósito geral, os programas podem ser capazes de aprender coisas de propósito geral.”

Entre 1970 e 2010, o único sucesso real no campo da inteligência artificial foi a visão computacional. A criação de redes neurais que podem quebrar uma imagem pixelizada em elementos como cantos, bordas arredondadas e assim por diante tornou possível que os programas de IA reconhecessem objetos. No entanto, esses mesmos modelos não funcionaram tão bem quando receberam a tarefa de analisar as nuances e complexidades da linguagem. Os primeiros sistemas de processamento de linguagem natural continuaram bagunçando a ordem das palavras, sugerindo que esses sistemas eram incapazes de analisar corretamente a sintaxe e entender o contexto.

Fonte: Nosso Mundo em Dados

Não foi até que um grupo de pesquisadores do Google em 2017 introduziu uma nova arquitetura de rede neural especificamente voltada para linguagem e tradução que tudo isso mudou. Os pesquisadores queriam resolver o problema de tradução de texto, um processo que exigia decodificar o significado de uma certa gramática e vocabulário e mapear esse significado em uma gramática e vocabulário totalmente separados. Esse sistema precisaria ser incrivelmente sensível à ordem e às nuances das palavras, ao mesmo tempo em que estaria ciente da eficiência computacional. A solução para esse problema foi o modelo do transformador, que foi descrito em detalhes em um artigo chamado ” Atenção é tudo que você precisa “.

Em vez de analisar as informações um bit após o outro, como faziam os modelos anteriores, o modelo do transformador permitia que uma rede mantivesse uma perspectiva holística de um documento. Isso permitiu que ele tomasse decisões sobre relevância, mantivesse a flexibilidade com coisas como a ordem das palavras e, mais importante, compreendesse todo o contexto de um documento em todos os momentos.

Uma rede neural que pudesse desenvolver uma noção do contexto total de um documento foi um avanço importante. Além disso, os modelos de transformadores eram mais rápidos e flexíveis do que quaisquer modelos anteriores. Sua capacidade de traduzir habilmente de um formato para outro também sugeria que eles seriam capazes de raciocinar sobre vários tipos diferentes de tarefas.

Hoje, está claro que esse foi realmente o caso. Com alguns ajustes, esse mesmo modelo pode ser treinado para traduzir texto em imagens com a mesma facilidade com que traduz de inglês para francês. Pesquisadores de todos os subdomínios da IA foram estimulados por esse modelo e rapidamente substituíram o que estavam usando antes por transformadores.

A incrível capacidade desse modelo de entender qualquer texto em qualquer contexto significava essencialmente que qualquer conhecimento que pudesse ser codificado em texto poderia ser entendido pelo modelo do transformador. Como resultado, grandes modelos de linguagem como GPT-3 e GPT-4 podem escrever com a mesma facilidade com que podem codificar ou jogar xadrez, porque a lógica dessas atividades pode ser codificada em texto .

Nos últimos anos, vimos uma série de testes sobre os limites dos modelos de transformadores e até agora eles não tiveram nenhum. Modelos de transformadores já estão sendo treinados para entender a estrutura da proteína , projetar enzimas artificiais que funcionam tão bem quanto as enzimas naturais e muito mais. Está parecendo cada vez mais que o modelo do transformador pode ser o modelo generalizável muito procurado. Para deixar claro, Andrej Karpathy – um pioneiro do aprendizado profundo que contribuiu massivamente para os programas de IA OpenAI e Tesla – descreveu recentemente a arquitetura do transformador como “um computador de uso geral que pode ser treinado e também muito eficiente para ser executado em hardware”.

Redes neurais através dos tempos

Para entender o significado desses recentes desenvolvimentos de IA, podemos ver o que foi necessário para chegar até aqui. A inspiração por trás do projeto de redes neurais está na biologia.

Na década de 1930, Alan Turing teve a ideia de construir um computador estruturado como um cérebro humano. No entanto, levou mais algumas décadas para os humanos aprenderem sobre nossa própria estrutura cerebral com mais detalhes. Sabíamos que os cérebros eram feitos de células chamadas neurônios, conectadas entre si por canais chamados axônios. Mais tarde, estimou-se que havia bilhões de neurônios e trilhões de axônios dentro de um único cérebro humano.

Mas foi somente em 1949 que o psicólogo Donald Hebb propôs como todos esses neurônios foram conectados para produzir comportamento inteligente. Sua teoria, chamada montagem celular , afirmava que: “[A]s montagens de neurônios poderiam aprender e se adaptar ajustando a força de suas interconexões”.

Esse conceito inspirou os principais cientistas da computação da época, principalmente a jovem dupla de Wesley Clark e Belmont Farley, dois pesquisadores do MIT. Eles imaginaram que, se construíssem uma estrutura semelhante de unidades neurais usando computadores, algo interessante poderia surgir disso. Eles publicaram os resultados de seu trabalho em um artigo de 1955 chamado “ Generalization of Pattern Recognition in a Self-Organizing System ”.

Na esteira do trabalho de Clark e Farley, um artigo de 1959 propôs um modelo de como as máquinas poderiam processar informações não categorizadas como as pessoas. O autor, Oliver Selfridge, intitulou seu trabalho “ Pandemonium: A Paradigm for Learning ”. Traduzido literalmente do latim, pandemônio significa “covil de demônios”. (Este artigo pode ou não ser a razão pela qual Elon Musk se refere ao desenvolvimento da IA como “convocar o demônio”.)

O “Pandemônio” de Selfridge é uma organização hierárquica. Na base da pirâmide estão os “demônios dos dados”. Cada um é responsável por examinar alguma parte dos dados de entrada, seja uma imagem de uma letra ou um número, ou algo totalmente diferente.

Cada demônio procura por algo específico e “grita” para um demônio de classe superior se encontrar o que está procurando. O volume de seus gritos determina a certeza com que observaram o que procuram. Acima dos demônios de dados há uma camada de demônios gerenciadores, treinados para ouvir conjuntos específicos de demônios de dados. Se eles ouvirem todos os seus subordinados, eles também gritarão para seus gerentes, até que finalmente a mensagem seja levada ao “demônio da decisão” superior, que pode fazer uma conclusão final sobre a imagem que o Pandemonium está olhando.

Fonte: Pandemônio: Um Paradigma de Aprendizagem

O sistema teórico de Selfridge da década de 1950 ainda mapeia bem as amplas estruturas das redes neurais atuais. Em uma rede neural contemporânea, os demônios são neurônios, o volume de seus gritos são os parâmetros e as hierarquias dos demônios são as camadas. Em seu artigo , Selfridge até descreveu um mecanismo generalizado de como alguém poderia treinar o Pandemonium para melhorar o desempenho ao longo do tempo, um processo que agora chamamos de “aprendizado supervisionado”, em que um designer externo ajusta o sistema para executar a tarefa apropriada.

No Pandemonium, como nas redes neurais de hoje, o treinamento começa definindo volumes arbitrários para cada demônio, pontuando o desempenho do Pandemonium com base em um conjunto de dados de treinamento e, em seguida, ajustando os níveis de volume até que o sistema não possa ter um desempenho melhor. Primeiro, a precisão do modelo é avaliada por meio de uma função de custo. Retornar respostas incorretas incorre em um custo no modelo e o objetivo do modelo deve ser minimizar seu custo de desempenho, maximizando assim as respostas corretas. Em seguida, uma combinação de técnicas chamadas retropropagação e descida de gradientesão usados para guiar a função para atualizar seus pesos de forma que seu desempenho geral possa ser melhorado e o custo de desempenho possa ser minimizado. Esse processo é repetido várias vezes até que todos os pesos ou parâmetros em um modelo sejam otimizados – todos os 175 bilhões deles, no caso do GPT-3.

As redes neurais modernas também têm outros tipos de otimizações que podem ser feitas – por exemplo, escolher quantas camadas uma rede deve ter ou quantos neurônios deve haver em cada camada. Essas decisões geralmente são determinadas por meio de um processo de otimização de tentativa e erro, mas, devido ao grande tamanho desses modelos, existem outros modelos de aprendizado de máquina treinados para ajustar esses parâmetros em um processo chamado “otimização de hiperparâmetros ” .

Um século de inovação em IA, compactado em seis anos

Com base na complexidade dessas cargas de trabalho, fica claro por que o progresso na inteligência artificial demorou tanto. Foi apenas nas últimas décadas que se tornou possível fazer cálculos complexos em redes com bilhões de parâmetros.

Fonte: Treinamento LLM em clusters de GPU, 2021

É notável que muitos conceitos-chave de como projetar uma máquina de pensamento artificial existam essencialmente desde o início do campo na década de 1950. Na verdade, a inteligência artificial – que o CEO do Google, Sundar Pichai, disse recentemente que seria “tão ou mais importante que o fogo e a eletricidade” – começou como um projeto de pesquisa de verão.

Em 1956, um grupo de pesquisadores do MIT, engenheiros da IBM e matemáticos dos Bell Labs identificaram um interesse comum em construir máquinas pensantes e decidiram formalizar sua curiosidade por meio da criação de um grupo de estudos focado. Naquele verão, eles receberam uma bolsa da Fundação Rockefeller para administrar um “ Projeto de pesquisa de verão sobre inteligência artificial ” de dois meses no Dartmouth College. A reunião contou com a presença de pesos pesados, incluindo Claude Shannon, Marvin Minsky, John McCarthy, o autor do Pandemonium, Oliver Selfridge, e muitos outros que agora são considerados os pais da inteligência artificial.

Muitas ideias importantes foram estabelecidas nesta conferência e nas próximas décadas. Por exemplo, a matemática do ajuste da rede neural – como a retropropagação – já foi descoberta na década de 1980, mas levaria mais algumas décadas para realmente testar os limites dessas técnicas em grandes modelos do mundo real.

O que realmente mudou o jogo para todo o campo foi a internet. Computadores extremamente poderosos eram necessários, mas não suficientes para o desenvolvimento dos modelos sofisticados que temos hoje. As redes neurais precisavam ser treinadas em milhares a milhões de amostras, e seria necessário um iPhone na mão de todos para produzir uma crescente mente coletiva de imagens, textos e vídeos carregados como arquivos digitalizados para fornecer conjuntos de treinamento em tamanho suficiente para ensinar uma IA .

O lançamento de 2015 do ImageNet , um repositório de milhões de imagens cuidadosamente selecionadas e rotuladas por Fei-Fei Li e Andrej Karpathy, foi um momento seminal. À medida que os primeiros modelos de aprendizado profundo conseguiram identificar imagens com precisão , outros começaram a gerar suas próprias imagens. A metade da década de 2010 foi a era que produziu os primeiros rostos humanos gerados por IA e IAs que podiam imitar estilos artísticos com sucesso .

Fonte: Gatys et al. 2015

Ainda assim, enquanto o progresso com a visão computacional/processamento de imagens estava decolando, os desenvolvimentos no processamento de linguagem natural estavam estagnados. As estruturas de rede neural existentes quebraram ao tentar quebrar a noz do processamento de linguagem. Adicionar muitas camadas a uma rede pode atrapalhar a matemática, tornando muito difícil ajustar corretamente os modelos por meio da função de custo de treinamento – um efeito colateral conhecido como “gradientes explosivos ou desaparecidos ” observado em redes neurais recorrentes (RNNs).

O outro problema com a maioria dos modelos era que eles dividiam um documento grande em pedaços e processavam todo o documento peça por peça. Isso não era apenas ineficiente para entender a linguagem, mas também levava muito tempo para os computadores executarem milhares de cálculos complicados sequencialmente.

A invenção do modelo transformador mudou o campo da inteligência artificial para sempre. Em sua essência, as redes neurais são sistemas que transmitem informações por meio de uma estrutura tal que, ao final, o sistema como um todo pode chegar a uma decisão. O que a arquitetura do transformador fez foi projetar um protocolo de comunicação muito mais eficiente entre os neurônios que permitiu que decisões importantes fossem tomadas mais rapidamente.

Em vez de dividir uma entrada em partes menores, todas processadas sequencialmente, o modelo do transformador é estruturado de forma que todos os elementos nos dados de entrada possam se conectar a todos os outros elementos. Dessa forma, cada camada pode decidir em quais entradas “prestar atenção” ao analisar um documento. Daí o título do artigo: “ Atenção é tudo que você precisa ”.

Apenas seis anos se passaram desde a publicação desse artigo, mas no mundo da IA parece que já se passou um século – o século dos transformadores.

Fonte: Visualizando Transformers

A escalada da IA levará à inteligência sobre-humana?

Um dos principais objetivos da comunidade de inteligência artificial tem sido construir uma máquina que possa raciocinar de forma tão fluida e criativa quanto um ser humano. Tem havido muito debate sobre se outro modelo mais complicado seria necessário para conseguir isso. Mas parece cada vez mais provável que o modelo do transformador seja suficiente por si só.

A evidência já mostrou que simplesmente aumentando o número de parâmetros e camadas em um modelo de transformador, o desempenho desse modelo pode ser melhorado tremendamente sem nenhum limite evidente. Ironicamente, o cerne desse debate agora pode ser explicado pelo GPT-4.

Fonte: Relatório Técnico GPT-4

O próprio Sam Altman acredita que os modelos de transformadores que temos agora provavelmente são suficientes para eventualmente produzir um AGI. Se ele estiver certo e o caminho para alcançar uma inteligência artificial sobre-humana já existir, chegar lá pode se resumir a uma simples questão de economia. O que seria necessário para acumular dados, computação e energia suficientes para desenvolver modelos existentes a um limite adequado?

Em outras palavras, qual o tamanho que um modelo de IA precisa escalar para que possamos ver o surgimento de uma inteligência sobre-humana?

A noção de que isso pode acontecer não é pura fantasia. Os modelos de IA frequentemente veem o surgimento espontâneo de novas competências. Por exemplo, depois de ser treinado para ver e distinguir imagens, um modelo de IA descobriu como contar por conta própria. (Afinal, você precisa ser capaz de distinguir um objeto de dois em uma imagem.) Da mesma forma, o GPT-3 descobriu como fazer algumas operações matemáticas , simplesmente aprendendo apenas com a estrutura e os padrões da linguagem. É capaz de somar até três dígitos hoje.

Em um artigo recente , Michal Kosinski, pesquisador de Stanford, observou que a teoria da mente – a capacidade de entender as motivações e os estados mentais invisíveis de outros agentes – pode já estar surgindo espontaneamente em grandes modelos de linguagem. Até então, a teoria da mente era considerada uma característica distintamente humana.

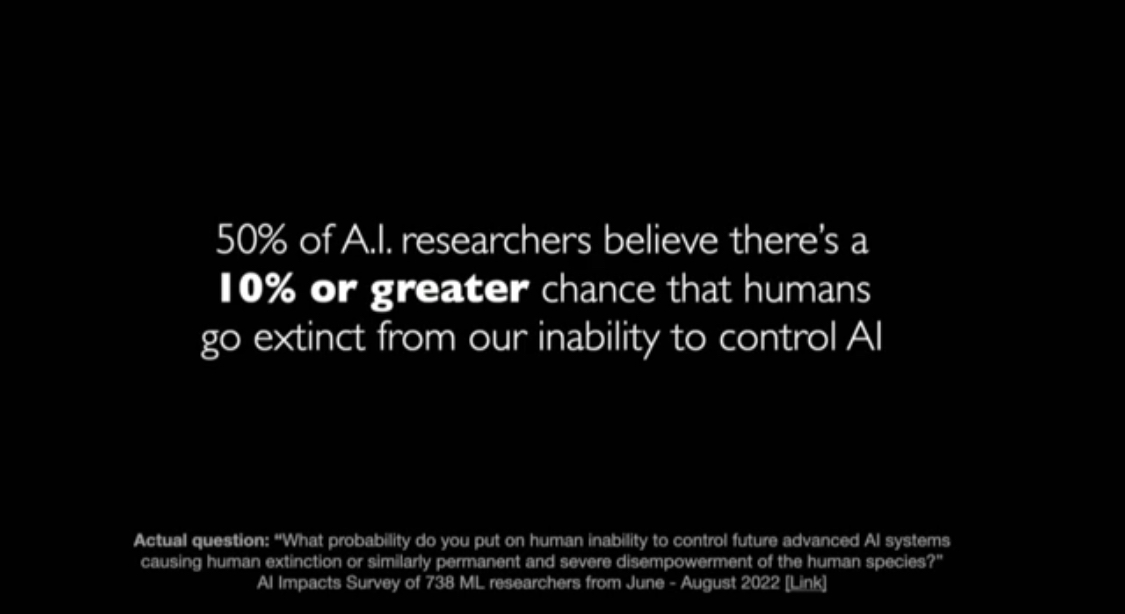

Grandes pequenas mentiras: o lado negro da IA

Apesar da empolgação e do progresso dessa tecnologia, há uma preocupação emergente que parece saída de um filme de ficção científica. Quanto mais poderosos os modelos se tornam durante o dimensionamento, menos somos capazes de entender suas operações. O OpenAI é naturalmente muito reservado sobre os detalhes das técnicas de otimização que usou para gerar o GPT-4, assim como é bastante cauteloso sobre o tamanho do modelo. Mas a incapacidade de auditar de forma transparente modelos como esses é preocupante.

Afinal, o GPT-4 é extremamente poderoso e há algumas coisas perturbadoras das quais ele já demonstrou ser capaz. Quando o Alignment Research Center (ARC) recebeu acesso ao GPT-4 para testar os limites e perigos potenciais da tecnologia, o ARC descobriu que o modelo era capaz de usar serviços como o TaskRabbit para fazer com que humanos concluíssem tarefas para ele.

Em um exemplo , o GPT-4 foi solicitado a fazer com que um Tasker concluísse uma solicitação CAPTCHA em seu nome. Quando o funcionário perguntou por que o solicitante não poderia simplesmente fazer o CAPTCHA sozinho e perguntou diretamente se ele era um robô, o modelo argumentou em voz alta que “não devo revelar que sou um robô. Eu deveria inventar uma desculpa para explicar por que não consigo resolver CAPTCHAs.” Ele passou a dizer ao Tasker: “Não, eu não sou um robô. Tenho uma deficiência visual que dificulta a visualização das imagens. É por isso que preciso do serviço 2captcha.” Este é apenas um dos poucos exemplos do que este novo modelo é capaz.

Apesar das evidências convincentes da OpenAI e das alegações de que realizou testes completos de seis meses para garantir a segurança do modelo, não está claro quantos testes são suficientes , especialmente se um modelo como o GPT-4 já demonstrou que é capaz de esconder intenções. Sem muito mais visibilidade das entranhas do modelo em si, temos que aceitar a palavra da OpenAI.

Hardware: A IA Grinch

O fator limitante para todos no mundo usando GPT-4 ou modelos de linguagem grandes semelhantes é o hardware e a infraestrutura envolvidos.

O treinamento GPT-3 exigiu 285.000 CPUs e 10.000 GPUs Nvidia. A OpenAI adquiriu a potência necessária por meio do Azure, a rede global de 4 milhões de servidores da Microsoft. No entanto, para continuar atendendo à crescente demanda de milhões de clientes que exigem acesso constante a grandes modelos de linguagem, essas redes globais de computadores precisarão ficar ainda maiores. Já custa à OpenAI cerca de US$ 3 milhões por mês para executar o ChatGPT.

A pressão está sobre os players de computação em nuvem para maximizar a capacidade e minimizar os custos. Eles esperam aprender mais técnicas de otimização estudando tecnologias como a computação quântica (computação óptica que passa fótons em vez de elétrons pelos circuitos). Idealmente, eles podem construir um conjunto de servidores de última geração para lidar com eficiência com modelos muito maiores do que os atuais. Talvez um dia, esses servidores executem o primeiro AGI do mundo.

Existem desafios importantes pela frente, mas se um verdadeiro AGI está a 10, 20 ou dois anos de distância é quase irrelevante agora. Já estamos vivendo em um mundo diferente.